Comment j'ai changé de travail sans bouger de ma chaise

- par Fabrice Bournisien - BoulotCela fait plusieurs années que j'assure la qualité d'overblog.com :

- Tests et validation "manuel" pendant des années,

- Gestion du support utilisateur par forum ou par mail,

- Mise en place des tests fonctionnels automatiques,

- Mise en place des changelog,

- Rôle de proxy Product Owner lorsque l'équipe est passé à Scrum,

- A l'occasion, j'ai aussi développé des fonctionnalités sur le projet lui-même,

- Et plein d'autres petites tâches pour assurer la qualité en général...

En début d'année, lors de mon entretien annuel avec ma hiérarchie, j'ai sous-entendu que je commençais à "m'ennuyer" : je n'avais plus assez de défis à me mettre sous la dent.

J'ai aussi demandé des rendez-vous à quelques reprises avec mon "n+2", pour lui exposer des problèmes d'organisation, et aussi mon ressenti sur le produit et sa qualité. (Je n'aime pas l'appeler mon "n+2", mais c'est plus simple pour en parler ici. Il mérite beaucoup plus que cela : il est à l'écoute, et chaque fois je sors de réunion "prêt à en découdre".)

A la recherche du Graal de l'emploi

A ce moment-là, j'ai mis à jour mon CV, mes informations sur les réseaux, et je suis passé en mode veille "un peu plus active" sur l'emploi dans mon domaine.

J'ai rapidement découvert plusieurs choses :

- J'ai acquis au sein de ma société une autorité "naturelle" dans le domaine de la Qualité, et des tests.

- J'ai une autonomie très importante pour faire mon travail, et j'aime ça !

- Les postes dédiées à la qualité et/ou aux tests ne courent pas les rues

- Certains postes dans le domaine ne me conviennent pas

- Se limiter à une région géographique limite encore plus les offres

J'ai du coup pensé à changer de carrière pour rester dans ma région, mais je n'avais pas envie de redevenir développeur "lambda" (et qu'on ne me parle pas de chef de projet). Je me suis même demandé pourquoi je restais dans l'informatique (quand je dis que je ratisse, je ratisse large).

Au printemps, j'allais au travail avec un peu moins d'entrain, et avec le recul, je me suis aperçu que je me faisais des montagnes de certains petits tracas sans importance. Mais hors de question pour moi de partir sans savoir où aller.

Le casse du siècle ?

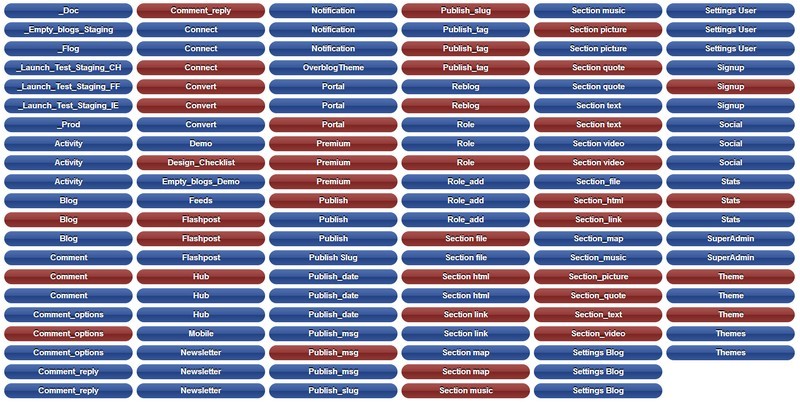

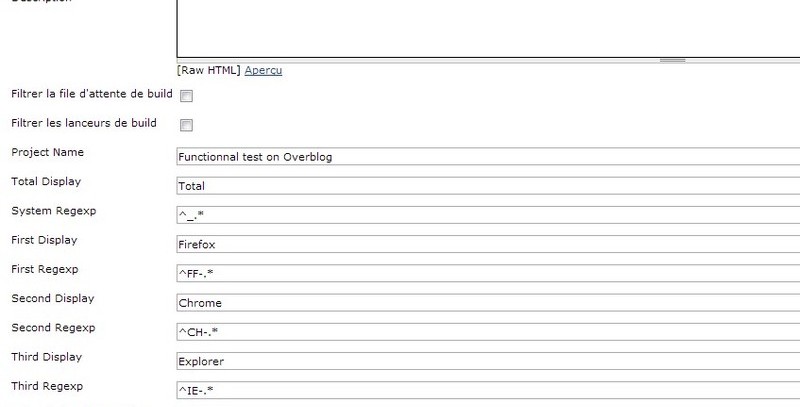

Et puis, au début de l'été, on m'a fait une proposition intéressante : * Mettre en place des tests automatiques sur des projets web * Travailler en binôme avec quelqu'un déjà en place * Travailler sur 5 ou 6 projets web distincts (mais ayant des parties communes) * Toucher à des domaines que je ne maîtrise pas : faire des tests sur du flash ou des applications mobiles, de beaux défis ! * Accompagner les équipes techniques pour améliorer la Qualité Ce poste paraissait trop beau pour être vrai, mais il était pourtant parfait pour moi. OverBlog fait partie du groupe Ebuzzing depuis plusieurs années. Ebuzzing diffuse un certains nombre de projets. Depuis cet été, j'assure maintenant la qualité de tous ces projets.

Ils vécurent heureux et eurent beaucoup d'enfants

Depuis, j'ai un nouveau travail.

- Je n'ai pas changé de bureau. Je suis toujours assis au même endroit, avec mes habitudes.

- Mon "n+2" est toujours le même. Pour moi, c'est vraiment une bonne chose : j'ai appris à l'apprécier, et à le respecter depuis longtemps.

- Je n'ai pas changé de collègues, mais la liste des collègues avec qui je travaille s'est allongée.

- Si depuis longtemps je codais "propre" et réutilisable sans même avoir besoin de le faire, depuis cet été je le met en pratique. Le temps "perdu" pour cela a "enfin" été rentabilisé.

- Travailler en binôme est stimulant. Il ne se passe pas une semaine sans qu'une idée de l'un de nous fasse rebondir l'autre pour affronter un problème particulier.

- Former mon binôme à mes méthodes de travail est intéressant. Il me permet de voir que certains choix ne sont pas forcément pertinents et logiques. Au bout de 4 mois, j'ai déjà repéré plusieurs fois que l'un finissait la phrase de l'autre : juste parfait à mes yeux.

- Pouvoir chaque jour travailler sur un projet différent est génial : je n'ai plus de routine (les habitudes sont ma hantise)

- Même si mon autonomie n'est pas aussi importante qu'avant, j'en ai quand même beaucoup. C'est plus que suffisant. (je connais beaucoup de gens qui voudraient avoir la moitié de celle que j'ai)